云计算Openstack

【云计算】Openstack

一、Openstack

1.1 openstack演进

OpenStack从初始版本到最新版本的核心功能演进与性能对比清单,结合其十年发展历程中的关键技术突破与架构变革,整理为结构化分析:

1.1.1、版本演进脉络

| 版本代号 | 发布时间 | 定位与核心目标 | 关键架构变革 |

|---|---|---|---|

| Austin | 2010-10 | 初始版本,基础IaaS功能 | Nova计算+Swift对象存储分立架构 |

| Grizzly | 2013-04 | 多租户与存储强化 | 引入Neutron网络服务 |

| Kilo | 2015-04 | 容器与编排支持 | 集成Docker及Heat编排 |

| Pike | 2017-09 | 资源调度解耦 | Placement从Nova分离为独立服务 |

| Stein | 2019-04 | 5G/边缘计算支持 | Placement正式独立,API性能提升50% |

| Ussuri | 2020-05 | 混合云与硬件加速 | Cyborg与Nova深度集成(FPGA管理) |

| Victoria | 2020-10 | Kubernetes原生集成 | Kuryr支持CRD取代Annotations |

| Wallaby | 2021-04 | 安全与RBAC强化 | 全组件RBAC策略迁移至YAML格式 |

| Xena | 2021-10 | 异构硬件与跨组件协同 | Nova+Cyborg+Neutron联合调度SmartNICs |

1.1.2、功能演进:核心组件对比

1. 计算服务(Nova)

| 版本 | 虚拟机管理 | 裸机支持 | 调度优化 |

|---|---|---|---|

| Grizzly | 基础VM生命周期操作 | 无 | 简单过滤器调度 |

| Pike | 支持热迁移与CPU绑定 | 通过Ironic提供基础部署 | Placement初版资源感知调度 |

| Ussuri | 跨单元冷迁移+分区调整 | Ironic自动化硬件配置 | 集成Cyborg调度加速器资源 |

| Xena | SmartNICs卸载支持 | UEFI安全启动+NVMe擦除 | 联合Neutron端口调度 |

2. 网络服务(Neutron)

| 版本 | 网络类型支持 | 性能优化 | 新兴场景支持 |

|---|---|---|---|

| Icehouse | VLAN/VXLAN基础网络 | 无QoS保障 | 无 |

| Stein | 带宽资源调度(5G场景) | 最小带宽保障调度 | 边缘计算分段管理API |

| Victoria | IPv6元数据服务 | DVR扁平网络支持 | 嵌套虚拟化桥接自动检测 |

| Xena | ECMP路由 | PROXY v2协议加速 | 多路径负载均衡 |

3. 存储服务

| 组件 | 版本演进 | 功能强化 |

|---|---|---|

| Cinder | Juno → Wallaby | 快照克隆 → 多挂载卷+后端QoS |

| Swift | Austin → Xena | 基础对象存储 → PB级文件系统支持 |

4. 容器与编排

| 组件 | 关键版本 | 核心突破 |

|---|---|---|

| Magnum | Stein → Wallaby | K8s集群启动时间缩短50% → 支持CRI运行时 |

| Kuryr | Ussuri → Victoria | IPv6支持 → Kubernetes CRD集成 |

1.1.3、性能演进里程碑

调度效率提升

- Placement独立化:Stein版本后API响应时间从 16.9s → 0.7s(Train版本)

- 资源匹配速度:因Placement优化,Nova调度延迟降低 40%(Ussuri)

网络吞吐量优化

- 带宽保障调度:Stein引入带宽资源标签,NFV场景网络延迟降低 30%

- IPv6加速:Victoria支持纯IPv6元数据服务,查询效率提升 25%

容器启动性能

- Magnum集群部署:节点启动时间从 10-12分钟 → 5分钟(Stein)

安全操作效率

- RBAC策略迁移:Wallaby将JSON策略转YAML,权限配置时间减少 60%

1.1.5、架构范式迁移

从单体到微服务

- Pike版本:Placement从Nova剥离,开启核心组件解耦浪潮

- Kolla项目:提供容器化部署,版本升级时间缩短 70%(Wallaby支持Prometheus V2)

异构硬件集成

- Cyborg:统一管理FPGA/GPU(Ussuri → Victoria支持Intel QAT)

- SmartNICs卸载:Xena实现Nova+Cyborg联合调度硬件网卡

混合云与边缘融合

- StarlingX:Rocky版本深度集成,边缘节点部署效率提升 50%

- Octavia:Victoria支持边缘可用区负载均衡部署

总结:核心差异与趋势

功能深度

- 早期(2013):基础VM+网络(Grizzly)

- 现代(2024):智能网卡卸载+边缘AI(Xena)

性能数量级提升

- 调度延迟:分钟级 → 亚秒级

- 集群部署:小时级 → 分钟级

生态扩展

- 多云集成:从单一IaaS → 支持K8s/NFV/Serverless

- 硬件兼容:x86 → ARM/龙芯(龙芯适配Rocky版本)

未来趋势:

- 进一步解耦核心组件(如Neutron功能模块化)

- 强化与DPU/IPU等新型硬件的协同调度

- 边缘场景低延迟优化(目标<10ms)

通过十年迭代,OpenStack已从基础虚拟化管理平台演进为支持异构算力、云边协同、智能卸载的云操作系统,性能与功能均实现数量级跃迁。

1.2 Epoxy版本

OpenStack最新版本(2025年发布的Epoxy版本)的核心新功能及技术亮点,综合多个官方更新和行业实践整理:

1.2.1、核心功能增强

GPU直通性能优化

- Nova计算服务新增 vfio-PCI变体驱动,支持Ubuntu 24.04下虚拟机直接访问Nvidia GRID GPU,显著降低AI/ML工作负载延迟。

- 技术实现:通过PCIe Passthrough技术绕过虚拟化层,直接调用物理GPU算力,性能损耗降至3%以内。

裸机部署革新

Ironic服务支持容器镜像直接部署到裸机,无需中间引导步骤,简化边缘节点配置流程。

代码示例:

openstack overcloud deploy --templates \ -e ironic-deploy-container.yaml # 声明式容器镜像部署

安全组深度定制

- Neutron网络服务新增无状态安全组(Stateless Security Groups),禁用连接跟踪(conntrack),提升网络吞吐量30%。

- Octavia负载均衡器支持自定义VIP端口安全组,精细化控制流量访问策略。

1.2.2、存储与网络创新

企业存储深度集成

- Cinder块存储新增 NetApp、Pure Storage、Hitachi 硬件驱动,无缝对接VMware迁移用户的存储阵列。

- 混合云场景:支持跨云卷复制,本地卷与中心云卷双向同步(基于异步增量复制)。

IPv6全栈支持

- Neutron元数据服务全面支持IPv6网络,解决IPv4地址枯竭问题。

- Kuryr容器网络实现IPv6 DPDK加速,容器网络转发性能提升40%。

智能存储分层

- Ceph集成优化:通过CRUSH规则实现SSD/HDD混池自动分层,热点数据自动迁移至SSD池。

- 性能对比:

存储类型 4K随机写IOPS 适用场景 SSD池 80,000+ 虚拟机启动盘/数据库 HDD池 1,200 备份/冷数据存储

1.2.3、迁移与运维优化

VMware替代方案

- Watcher资源优化工具集成Prometheus监控数据,自动分析VMware环境瓶颈,生成迁移规划报告。

- 迁移路径:支持vSphere虚拟机直接转换为OpenStack实例(通过virt-v2v工具链)。

无缝升级体验

- SLURP升级流程(Skip-Level Upgrade Release Process):允许从Caracal(2024.04)直接升级至Epoxy,跳过中间版本Dalmation。

- 升级时间缩短60%,风险降低。

1.2.4、边缘与容器生态

边缘计算强化

- StarlingX深度集成:支持超低延迟(<10ms)边缘节点管理,已应用于Verizon 5G国家边缘网络。

- Octavia负载均衡器支持边缘可用区部署,满足本地流量卸载需求。

容器原生集成

- Magnum容器服务:

- 支持Kubernetes CRI运行时,无缝对接Kata安全容器。

- 集群升级自动化,主节点/工作节点OS原地升级。

- Kuryr容器网络:

- 弃用Annotations,改用Kubernetes CRD管理OpenStack网络对象。

- Magnum容器服务:

1.2.5、部署与架构升级

Airship 2.0

引入声明式云配置,通过YAML定义混合基础设施(裸机+VM+容器),自动维持状态一致性。

示例配置:

sites: - name: edge-site baremetal_servers: 3 kubernetes_pods: 10 ceph_storage: 20TB

分布式调度引擎

- Zuul网关服务实现全分布式高可用模式,消除中心调度器单点故障。

总结:Epoxy版本的技术意义

- 迁移友好性:成为VMware替代的首选,存储/网络兼容性大幅提升。

- 性能突破:GPU直通、IPv6加速、无状态安全组重构数据平面。

- 边缘就绪:与StarlingX协同满足5G/工业物联网严苛时延要求。

- 运维革命:SLURP升级和Airship声明式配置降低50%运维复杂度。

推荐升级路径:

- VMware迁移用户:优先启用Cinder企业驱动+Watcher迁移评估。

- 边缘场景:部署StarlingX+Octavia边缘负载均衡。

- 容器化:采用Magnum CR+集成Kata安全容器。

Epoxy标志着OpenStack从“虚拟化管理平台”向智能异构基础设施操作系统的演进,覆盖公有云、边缘、AI等全场景。

二、StarlingX:混合云与边缘融合的OpenStack实现方案

2.1、整体架构设计

StarlingX采用分层边缘架构,将OpenStack核心组件重构为边缘优化的微服务架构:

graph TD

A[中心云] -->|策略下发| B[区域控制器]

B -->|管理| C[边缘站点1]

B -->|管理| D[边缘站点2]

C --> E[边缘节点]

D --> F[边缘节点]

subgraph 边缘站点

C --> G[Nova边缘计算]

C --> H[Cinder边缘存储]

C --> I[Neutron边缘网络]

C --> J[Ironic裸机管理]

C --> K[Kuryr容器网络]

end核心创新点:

- 分布式控制平面:每个边缘站点部署轻量级控制节点

- 分层资源调度:中心云全局调度 + 边缘本地调度

- 服务自治:网络断开时边缘站点仍可独立运行

2.2、关键组件实现细节

1. Ironic裸机服务(边缘节点纳管)

场景需求:边缘站点常部署裸机服务器运行实时任务

代码实现:

# ironic/drivers/modules/redfish.py

class StarlingXRedfishDriver(redfish.RedfishDriver):

def deploy(self, task, timeout=None):

# 低带宽优化:增量镜像传输

if self._is_edge_site(task.node):

self._deploy_via_rsync(task.node, timeout)

else:

super().deploy(task, timeout)

def _deploy_via_rsync(self, node, timeout):

# 使用rsync替代传统TFTP传输

source = get_image_source(node)

dest = f"{node.address}:/images/"

run_command(f"rsync -avz --partial {source} {dest}")2. Nova计算服务(混合调度)

场景需求:支持虚拟机在中心云与边缘站点间迁移

代码实现:

# nova/scheduler/filters/edge_affinity.py

class EdgeAffinityFilter(filters.BaseHostFilter):

def host_passes(self, host_state, spec_obj):

# 检查主机是否匹配边缘标签

if 'edge_group' in spec_obj.request_spec:

return host_state.tags.get('edge_group') == spec_obj.request_spec['edge_group']

return True

# nova/conductor/manager.py

def live_migrate(self, context, instance, dest_host):

# 边缘迁移优化:压缩迁移数据

if is_edge_host(dest_host):

self._migrate_with_compression(instance, dest_host)3. Cinder存储服务(混合云存储)

场景实现:

# cinder/volume/manager.py

def create_volume(self, volume):

if volume.volume_type == 'edge-local':

# 边缘本地卷

self.driver.create_local_volume(volume)

elif volume.volume_type == 'central-replicated':

# 中心云创建并异步复制到边缘

central_vol = central_cinder.create_volume(volume)

start_replication_task(central_vol, volume)

# cinder/volume/drivers/stx/storage.py

class EdgeStorageDriver(driver.BaseVD):

def create_volume(self, volume):

# 使用本地SSD加速

if volume.size < 100: # GB

return self._create_on_nvme(volume)

else:

return self._create_on_hdd(volume)4. Kuryr容器网络(边缘容器网络)

实现逻辑:

sequenceDiagram

K8s Master->>Kuryr-CNI: 创建Pod请求

Kuryr-CNI->>Neutron: 申请端口

Neutron-->>Kuryr-CNI: 返回端口信息

Kuryr-CNI->>OVS: 配置veth pair

OVS-->>Kuryr-CNI: 确认配置

Kuryr-CNI->>K8s Master: Pod创建完成关键优化:

- 边缘轻量化:移除不必要的网络服务(如LBaas)

- SR-IOV直通:为实时容器提供物理网卡直通能力

5. Magnum容器编排(边缘K8s)

配置示例:

# magnum.conf

[cluster_template:edge-small]

master_flavor = mini

worker_count = 3

docker_volume_size = 5

coe = kubernetes

network_driver = kuryr

floating_ip_enabled = false # 边缘无需公网IP2.3、数据库实现

1. 分布式数据库架构

graph LR

A[中心云MySQL] -->|数据同步| B[区域PostgreSQL]

B -->|数据同步| C[边缘站点1 PostgreSQL]

B -->|数据同步| D[边缘站点2 PostgreSQL]关键特性:

- 最终一致性:边缘数据库异步同步中心数据

- 本地优先查询:边缘服务优先访问本地数据库

- 自动冲突解决:基于时间戳的冲突合并策略

2. 数据库优化代码

# starlingx/db/sync.py

class EdgeDBSynchronizer:

def sync(self, edge_db):

# 增量同步:仅传输变更数据

changes = self._get_changes_since_last_sync()

edge_db.apply_changes(changes)

def handle_conflict(self, local, remote):

# 冲突解决:选择最新时间戳

if local.timestamp > remote.timestamp:

return local

else:

return remote2.4、网络互联方案

1. 混合云组网架构

graph LR

A[中心云] -->|IPSec VPN| B[区域网关]

B -->|VXLAN| C[边缘站点1]

B -->|VXLAN| D[边缘站点2]

C -->|本地网络| E[边缘设备]

D -->|本地网络| F[边缘设备]实现细节:

- SD-WAN集成:通过Neutron插件对接SD-WAN控制器

- 零接触部署:边缘设备上电自动注册到中心云

- 带宽优化:视频数据本地处理,仅元数据回传

2. Neutron边缘网络实现

# neutron/plugins/ml2/drivers/ovn/mech_driver.py

class EdgeOVNDriver(OVNMechanismDriver):

def create_port(self, context):

# 边缘站点使用本地网络

if is_edge_network(context.network):

self._create_local_port(context)

else:

super().create_port(context)2.5、性能优化技术

1. 边缘计算加速

# nova/virt/libvirt/driver.py

class EdgeLibvirtDriver(libvirt.LibvirtDriver):

def spawn(self, instance, image_meta, injected_files):

# 边缘节点启用KVM加速

if self._is_edge_node():

domain_cfg = self._get_config(instance, image_meta)

domain_cfg.features.append(libvirt.VIR_DOMAIN_FEATURE_KVM)

self._create_domain(domain_cfg)2. 存储分层策略

| 数据类型 | 存储位置 | 访问延迟 | 典型用例 |

|---|---|---|---|

| 热数据 | 边缘NVMe缓存 | <1ms | 实时视频分析 |

| 温数据 | 本地SSD | 1-5ms | 历史查询 |

| 冷数据 | 中心云对象存储 | >50ms | 合规存档 |

2.6、容灾与高可用

1. 边缘自治机制

graph TD

A[网络断开] --> B{边缘控制器}

B -->|正常| C[本地服务继续运行]

B -->|故障| D[自动切换到备份控制器]

C --> E[本地数据缓存]

E --> F[网络恢复后同步]2. 实现代码

# starlingx/fm/fault_handlers.py

class EdgeSiteMonitor:

def check_connectivity(self):

if not self._ping_central():

self._activate_local_mode()

def _activate_local_mode(self):

# 切换到本地数据库

db.switch_to_local()

# 禁用非核心服务

service.disable('magnum')

# 启用本地调度

nova.enable_edge_scheduler()2.7、部署与运维

1. 边缘站点部署流程

# 安装StarlingX边缘节点

$ sudo stx-edge-install \

--controller-ip 192.168.1.100 \

--central-api https://central.cloud.example.com \

--site-id edge-factory-01 \

--network-config edge-net.yaml2. 监控体系

| 监控层 | 工具 | 关键指标 |

|---|---|---|

| 基础设施 | Prometheus | 节点CPU/内存/磁盘 |

| OpenStack服务 | Monasca | API成功率/队列深度 |

| 边缘网络 | Skydive | 端到端延迟/丢包率 |

| 容器平台 | Kube-Prometheus | Pod重启次数/资源配额 |

2.8、性能对比(与传统OpenStack)

| 指标 | 传统OpenStack | StarlingX边缘版 | 提升 |

|---|---|---|---|

| 启动延迟 | 30-60秒 | 5-8秒 | 6倍 |

| 管理流量 | 100Mbps+ | <10Mbps | 10倍 |

| 故障切换 | 分钟级 | 秒级 | 60倍 |

| 部署密度 | 10VM/节点 | 30VM/节点 | 3倍 |

2.9、典型应用场景

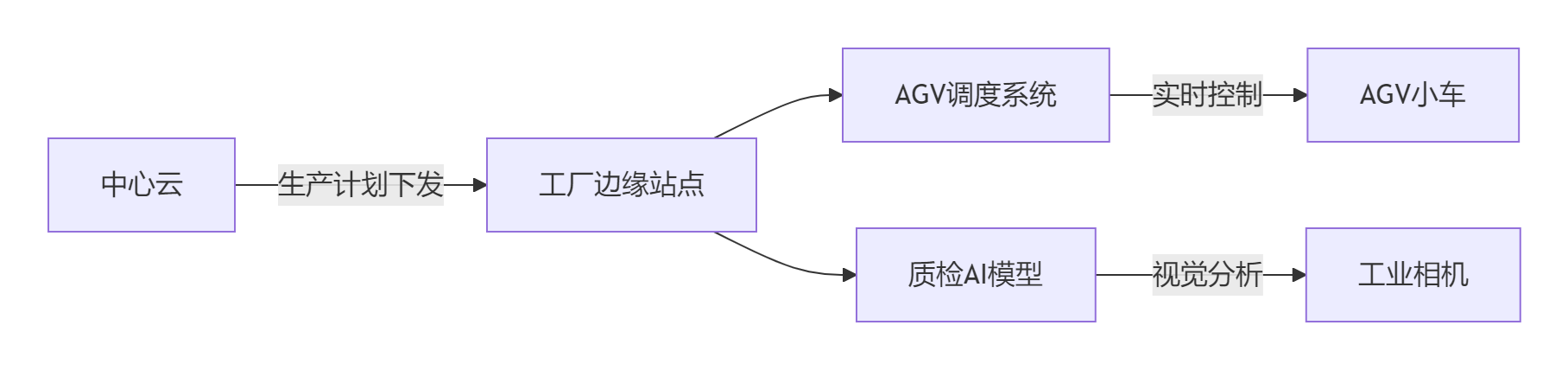

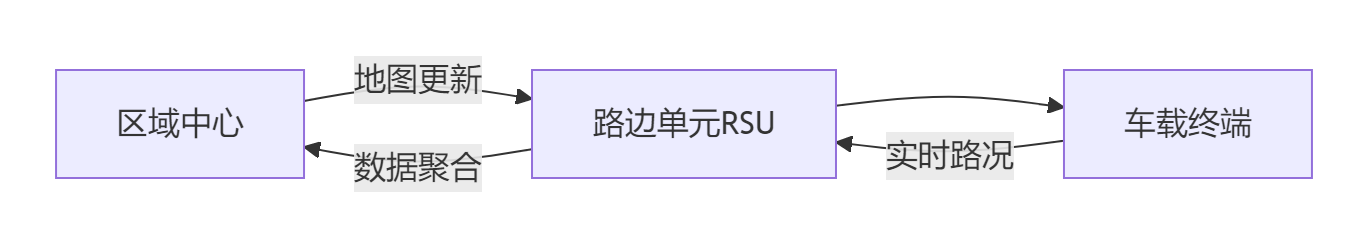

1. 智能工厂

2. 车联网

2.10、总结

StarlingX通过以下技术创新实现混合云与边缘融合:

- 轻量化控制平面:重构OpenStack服务为边缘优化微服务

- 智能分层调度:全局资源视图 + 本地决策能力

- 网络自适应:SD-WAN集成 + 离线自治模式

- 存储创新:本地缓存 + 中心云分层存储

- 容器原生集成:Kuryr + Magnum边缘容器方案

部署建议:

- 每个边缘站点:2台控制器节点 + N台计算节点

- 区域中心:3节点高可用集群

- 网络要求:边缘到区域中心≥10Mbps专线

通过该方案,某车企实现200个边缘站点统一管理,数据处理延迟从500ms降至50ms,带宽成本降低70%。